Jak pewnie wielokrotnie

słyszeliście, zdaniem kontrarian to właśnie efekt „miejskich wysp

ciepła” (UHI) ma odpowiadać w dużej części za (rzekomo) obserwowane

ocieplenie: w myśl tej teorii rozrastające się miasta pochłaniają

kolejne stacje meteorologiczne i zmieniają ich warunki

mikroklimatyczne, przez co mierzone tempo wzrostu temperatury wydaje

się wyższe, niż w rzeczywistości.

Głównym popularyzatorem tej tezy jest emerytowana telewizyjna pogodynka, Anthony Watts, autor bloga Watts Up With That?,

jednak przeświadczenie że efekt „miejskich wysp ciepła” ma duży wpływ

na trendy temperaturowe, jest wśród „sceptyków” powszechne. Argumenty

Wattsa są bowiem bardzo przekonujące, przynajmniej dla laików: w 2007

roku rozpoczął on „audyt fotograficzny” stacji meteorologicznych

rozmieszczonych w Stanach Zjednoczonych, bezlitośnie dokumentując

obecność klimatyzatorów, betonowych nawierzchnii, grilli i innych

niepożądanych elementów w bezpośrednim sąsiedztwie czujników

pomiarowych. Strona projektu Wattsa, surfacestations.org, wypełniona

jest zdjęciami „dobrych” stacji, które mierzą spadek temperatury, oraz

„złych” (zurbanizowanych) stacji, które wykazują ocieplenie.

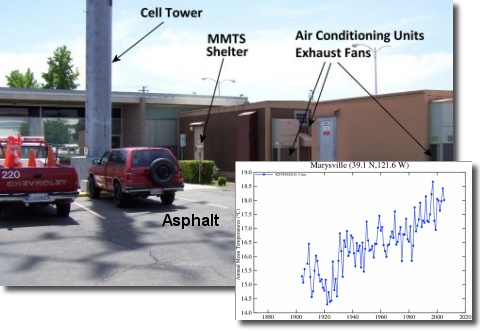

Żeby nie być gołosłownym, weźmy przykład opisany w cytowanym w poprzedniej notce polskim blogu:

Jednym z najlepszych przykładów tego jak umiejscowienie

stacji pomiarowej wpływa na odczyt temperatury jest przykład z

Marysville (Kalifornia) oraz położonej zaledwie kilkadziesiąt

kilometrów dalej stacji w Orland. Proszę zwrócić uwagę na diametralnie

różne odczyty!

„Zła” stacja Marysville i mierzona przez nią temperatura wygląda tak:

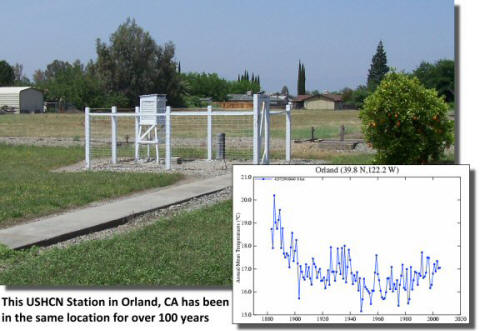

W odróżnieniu od niej „dobra” stacja Orland wygląda tak:

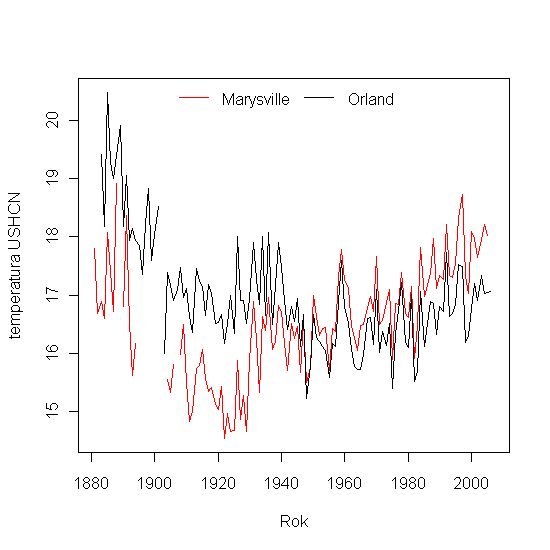

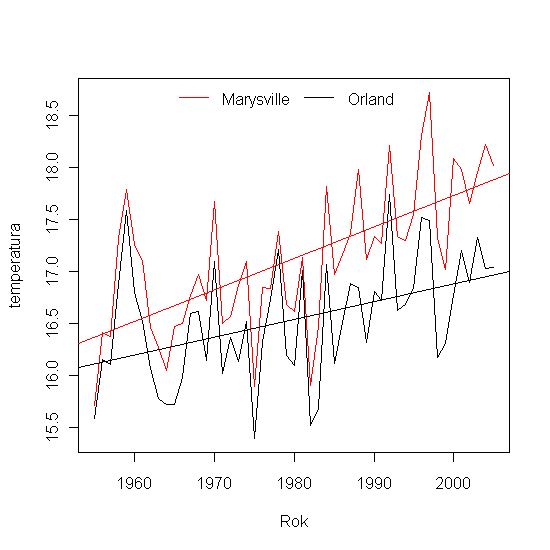

Faktycznie, jest to świetny przykład, choć na coś zupełnie innego niż

wydawało się to „sceptykom”. Jeśli bowiem zamieścimy obie krzywe zmian

temperatury na jednym wykresie, zobaczymy następujący obrazek:

Odczyty nie są już teraz „diametralnie różne”: efekt ten osiągnięto

przez narysowanie ich w różnych skalach. W rzeczywistości oba szeregi

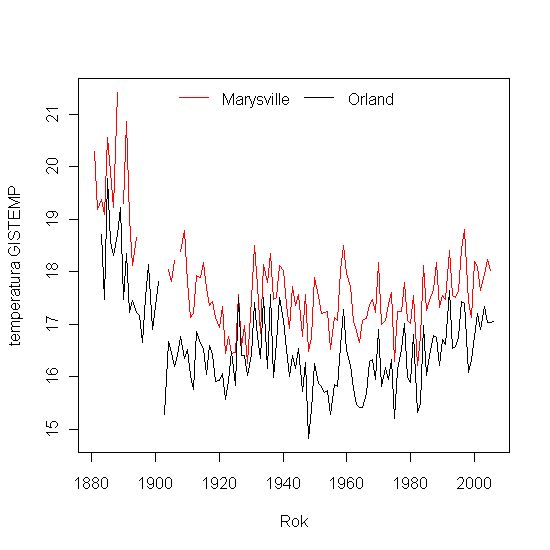

mają wspólne, charakterystyczne cechy: średnia temperatura roczna

mierzona w obu stacjach była bardzo wysoka pod koniec XIX wieku, po

czym gwałtownie spadła przed rokiem 1930-tym, i znów zaczęła rosnąć.

Widzimy także, że dane z pierwszych 20 lat zawierają luki i

nieciągłości, które mogą wyjaśniać pochodzenie raptownego ochłodzenia.

Jeśli popatrzymy na dane z ostatnich 50 lat, zobaczymy że w obu

przypadkach temperatura rośnie… choć w zurbanizowanym Marysville

szybciej, niż w rolniczym Orland. Znaleźliśmy więc niesławną „miejską

wyspę ciepła”, która sztucznie zwiększyła trend wzrostu temperatury w

Marysville.

I tutaj dochodzimy do istotnej części problemu: konstrukcja szeregu

czasowego temperatur nie polega tylko na prostym uśrednieniu wszystkich

danych, zarówno „dobrych” jak i „złych”. Wcześniej dane ulegają

kontroli jakości i homogenizacji, czyli procesowi usuwania z nich

błędów oraz czynników „nieklimatycznych” zmieniających odczyty

temperatury, takich jak właśnie urbanizacja.

Przykładowo, oczywiste błędy (np. źle odczytane cyfry ze starej

dokumentacji meteorologicznej) są wyszukiwane metodami statystycznymi:

wyniki odległe od średniej wieloletniej o więcej niż 5 odchyleń

standardowych, są oznaczane i porównywane z danymi pochodzącymi z

sąsiadujących lokalizacji — jeśli tam nie występują, są odrzucane.

Szeregi czasowe są następnie przeszukiwane pod kątem nieciągłości,

czyli miejsc w których kilkuletnia średnia nagle skokowo zmienia

wartość.

Uwzględnienie efektu „miejskich wysp ciepła” jest nieco bardziej

skomplikowane, gdyż wymaga sieci „dobrych”, tj. niezurbanizowanych

stacji. W opisanym wyżej przypadku, dla Marysville taką stacją jest

pobliskie Orland. Algorytm GISTEMP oblicza w takich przypadkach różnicę

trendów pomiędzy stacją z UHI, a stacjami niezurbanizowanymi, po czym

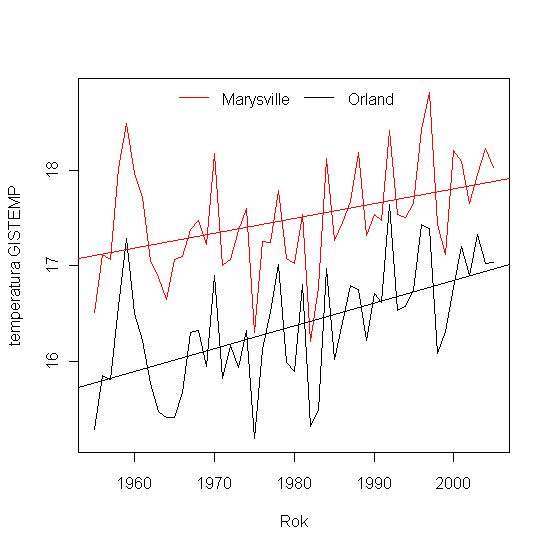

nanosi odpowiednie poprawki dla tej pierwszej. Efekt jest następujący:

Dla ostatnich 50 lat widzimy, że po poprawkach homogenizacyjnych

Marysville ociepla się niemal w tym samym tempie co Orland (a w

rzeczywistości nieco wolniej):

Innymi słowy: w analizie GISTEMP w trendach długoletnich uczestniczą

tylko „dobre”, niezurbanizowane stacje, przez co wpływ „miejskich wysp

ciepła” jest zminimalizowany.

Oczywiście, to tylko dwie stacje, a metodologia GISS opiera się o

założenie, że wartościowanie stacji jako „dobre” i „złe” jest poprawne.

GISS korzysta tutaj z kilku źródeł informacji — zarówno meta-danych

dostarczanych przez służby zarządzające siecią stacji (w tym przypadku

NOAA), jak i zdjęć satelitarnych obrazujących zanieczyszczenie

świetlne, takich jak to:

„Sceptycy” przekonywali jednak (nie bez słuszności), że nie można

ufać tej klasyfikacji, gdyż zdjęcia satelitarne nie pokażą grilla

ustawionego tuż obok termometru. Stąd właśnie projekt surfacestations.org

Anthony’ego Wattsa, który miał wykazać jak bardzo niewiarygodne są

„oficjalne” dane podawane przez takie instytucje badawcze jak GISS i

NOAA.

Projekt ruszył latem 2007, i dzięki ogromnemu zapałowi sceptyków już

po kilku miesiącach udało się im odwiedzić, sfotografować i

skatalogować aż 30% z 1221 amerykańskich stacji sieci USCHN. W tym

momencie historia zaczyna być naprawdę ciekawa: jeden ze „sceptyków”

(czy też, według jego własnej nomenklatury, „agnostyków”), John Van

Vliet, postanowił wykorzystać utworzoną klasyfikację do replikacji

danych GISS dla terytorium USA. Ideą Johna było stworzenie prostego

algorytmu (nazwanego OPENTEMP)

do obliczania szeregów czasowych na podstawie surowych danych ze stacji

pomiarowych. Algorytm z założenia nie miał zawierać żadnych procedur

homogenizacyjnych, uważanych przez „sceptyków” za podejrzane, więc

podstawą obliczeń miały być wyłącznie najlepsze, niezurbanizowane

stacje, których lista została opracowana przez ochotników z

surfacestations.org.

Spodziewano się, że analiza taka wykaże, iż ocieplenie obserwowane w

drugiej połowie XX wieku jest znacznie mniejsze niż w analizie GISS,

bądź w ogóle nie istnieje. John Van Vliet ogłosił jednak z pewnym zakłopotaniem:

It seems to me that the GISTEMP program (with all its flaws

and including bad stations) gives results that are very close to my

results using only the best stations. This is particularly true from

about 1970 onwards.

I suspect that some of the remaining differences

will be reduced when the complete network of good stations (CRN=1 or 2)

is available.

[…]

To be honest, this is starting to look like a great validation of GISTEMP.

[…]

There have been a lot of accusations here that Hansen et al are fudging

the numbers to show an artificial warming trend. My results show the

same trend with the best stations and no adjustments applied.

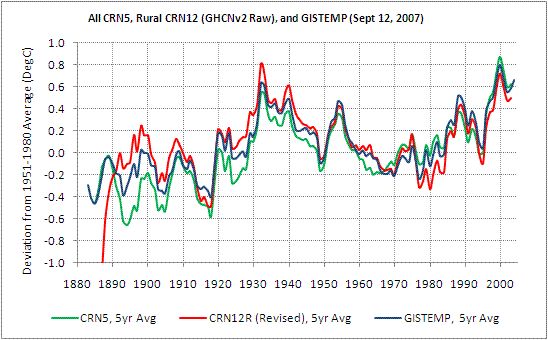

Porównanie analizy GISTEMP z OPENTEMP dla najlepszych (CRN1-2) i najgorszych (CRN5) stacji wygląda następująco:

Źródło: John Van Vliet, opentemp.org

Konsternacja „sceptyków” była ogromna. Większość z nich uznała, że

wyniki te potwierdzają tylko jak głęboko sięga spisek klimatologów,

którzy zmodyfikowali także dane „najlepszych” stacji pomiarowych. Inni,

jak Anthony Watts, stwierdzili że analiza Van Vlieta jest

„niekompletna”, i że po sklasyfikowaniu większej ilości stacji GISTEMP

zostanie sfalsyfikowany. Bardzo charakterystyczna była reakcja mentora

Wattsa, Stevena McIntyre z bloga ClimateAudit, który po latach ataków

na metodologię GISS w styczniu 2009 roku przyznał:

surfacestations.org has made a concerted effort to identify

high-quality stations within the USHCN network (CRN1-2 stations) and

preliminary indications are that the GISS U.S. estimate will not differ

greatly from results from the „best” stations (though there will

probably be a little bias.)

Jednocześnie McIntyre znalazł nowy cel „audytorów”:

The only network where a plausible adjustment is made is

the GISS US network (representing less than 2% of the world’s surface,

as NASA GISS reminds us.) While GISS US results are plausible, outside

the US, the GISS adjustment is a pig’s breakfast and no sane person can

claim that they live up to the warranty. What makes this frustrating is

that the US temperature history (GISS version) had 1934 as a record

year – a result that was at variance with the other indices and other

parts of the world. Is this because this is the only network/country

combination with an effective UHI adjustment or because of a unique

„regional” climate history in the US?

Jest to oczywiście nonsens — zjawiska takie jak zmiany rozmieszczenia gatunków roślin i zwierząt,

albo okresów wegetacyjnych, migracji i reprodukcji, albo topnienie

lodowców górskich i szelfowych takich jak Larsen B, pokazują że w dużej

części świata ocieplenie nie jest artefaktem złej metodologii

prowadzenia pomiarów temperatury.

Wyniki Van Vlieta zadały poważny cios projektowi

surfacestations.org. Kiedy okazało się, że potwierdzi ona rzetelność

analiz, które miała obalić, ochotnicy Wattsa stracili zapał do dalszej

pracy. W efekcie dzisiaj, 2 lata później, „audytowi” zostało poddane

tylko 70% stacji. Pikanterii sprawie dodaje fakt, że po tym jak NOAA opublikowała kilka miesięcy

temu wyniki własnej wewnętrznej analizy, opartej o klasyfikację

surfacestations.org, wściekły Watts ogłosił, że nie zamierza publikować

żadnych dodatkowych danych aż projekt zostanie zakończony,

uniemożliwiając w ten sposób analizy oparte o „niekompletne” dane.

Byłoby to nawet całkowicie zrozumiałe („wyłączność” na pozyskane ciężką

pracą dane należą do autorów oryginalnych badań, i zwykle są

upubliczniane dopiero po „oznaczeniu terytorium” w czasopismach

naukowych), gdyby nie liczne wypowiedzi Wattsa, który krytykował

klimatologów za „ukrywanie” własnych danych przed „audytorami”, oraz

gdyby nie to, że ani niekompletność danych, ani nawet brak ich analizy

nie powstrzymała Wattsa przed insynuowaniem, że instrumentalne pomiary temperatury są niewiarygodne.

Projekty surfacestations i OPENTEMP są (niezamierzonym) przykładem

na to, że nawet amatorzy mogą coś wnieść do nauki. Z drugiej strony

pokazują też, że większość procesu naukowego polega na „nudnym”

potwierdzaniu hipotez zerowych, a nie przepisywaniu podręczników na

nowo po „rewolucyjnych” odkryciach współczesnych Koperników czy

Einsteinów.

Źródło: Doskonale Szare

Źródło: Doskonale Szare