Naukowcy już od ponad 40 lat przygotowują prognozy zmiany klimatu wykorzystując coraz bardziej zaawansowany modele numeryczne. Bazując na fizyce atmosfery, oceanu i biogeochemii, modele te odgrywają ważną rolę w naszym zrozumieniu klimatu Ziemi oraz jego możliwych zmian w przyszłości. W dyskusjach często pojawiają się pytania o to, na ile poprawne były przygotowane za ich pomocą projekcje. Co jakiś czas można też usłyszeć, że klimat nie ociepla się aż tak bardzo, jak przewidywano.

Zebraliśmy więc najbardziej znane prognozy, poczynając od 1973 roku, aby z perspektywy czasu sprawdzić, na ile okazały się trafne. Wykorzystywane w prognozach modele pochodzą od pięciu różnych organizacji, różnią się też stopniem złożoności, od relatywnie prostych modeli bilansu energii, aż po najbardziej zaawansowane modele ziemskiego systemu klimatycznego. We wszystkich przypadkach, aby ułatwić porównanie wyników, zostały one odniesione do wspólnego okresu bazowego 1970-1990.

Rysunek 1. Zobrazowanie postępów w modelowaniu klimatu. Połowa lat 70. XX wieku: model obejmuje promieniowanie słoneczne, efekt cieplarniany, podstawowe zjawiska meteorologiczne, takie jak opady. Połowa lat 80. XX wieku: dochodzi powierzchnia lądowa z roślinnością, pokrywa lodowa i zachmurzenie. FAR (pierwszy raport IPCC): dochodzi ocean traktowany jako nieruchomy zbiornik wodny. SAR (drugi raport IPCC): dochodzą aerozole siarczanowe i wulkany. TAR (trzeci raport IPCC): dochodzą inne aerozole, cykl węglowy, rzeki i cyrkulacja oceaniczna. AR4 (czwarty raport IPCC): dochodzi dynamicznie reagująca roślinność i reakcje chemiczne.

Sawyer, 1973

Jedną z pierwszych prognoz przyszłego ocieplenia przygotował John Sawyer z brytyjskiego Met Office w 1973. W artykule opublikowanym w czasopiśmie Nature przewidywał, że w okresie 1969-2000 koncentracja CO2 w atmosferze zwiększy się o 25%, a temperatura powierzchni wzrośnie o 0,6°C. Sawyer przyjął czułość klimatu (wzrost temperatury powierzchni w odpowiedzi na podwojenie atmosferycznej koncentracji CO2) równą 2,4°C – co dość dobrze odpowiada aktualnie uznawanemu za najlepsze oszacowaniu 3°C.

W odróżnieniu od prognoz, które omówimy dalej, w przewidywaniach Sawyera nie znajdziemy oczekiwanych wartości temperatury w kolejnych latach. Autor podał tylko wartość w roku 2000. Jego oszacowanie (wzrost średniej temperatury o 0,6°C) okazało się całkiem trafne – w rzeczywistości zmiana wyniosła (zależnie od serii pomiarowej) 0,51-0,56°C. Sawyer przeszacował trochę koncentrację CO2 w atmosferze, którą przewidywał na 375-400 ppm, podczas gdy w rzeczywistości w roku 2000 wyniosła ona 370 ppm.

Broecker, 1975

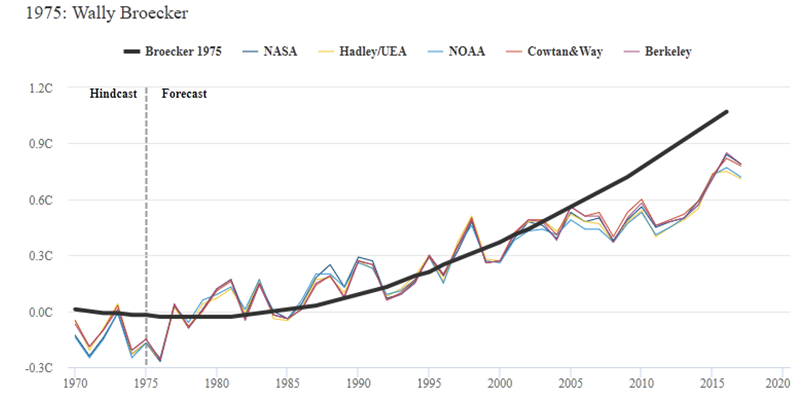

Pierwsza „ciągła” prognoza przyszłych zmian temperatury spowodowanych globalnym ociepleniem została opublikowana w czasopiśmie Science przez prof. Wally’ego Broeckera z Columbia University. Broecker wykorzystał prosty model bilansu energetycznego i posłużył się scenariuszem dalszego szybkiego wzrostu atmosferycznej koncentracji CO2. Prognoza Broeckera przez pierwsze ćwierć wieku całkiem nieźle pasowała do obserwacji, jednak później prognozowany przez niego wzrost temperatury okazał się zawyżony.

Rysunek 2. Prognoza ocieplenia klimatu przedstawiona przez Broeckera w 1975 roku (gruba czarna linia), porównana z seriami pomiarowymi NASA, NOAA, HadCRUT, Cowtan i Way, oraz Berkeley Earth (cieńsze linie kolorowe) od 1970 do 2020. Okres bazowy 1970-1990.

Przyczyn tego przeszacowania było kilka.

Broecker przeszacował m.in. tempo wzrostu emisji CO2 i w konsekwencji stężenia tego gazu w atmosferze. W roku 2000 Broecker prognozował stężenie 373 ppm – bardzo bliskie zmierzonego na Mauna Loa 370 ppm. W 2016 roku prognozował już jednak 424 ppm, podczas gdy faktycznie wyniosło ono ok. 400 ppm.

Podobnie jak Sawyer, Broecker użył czułości klimatu równej 2,4°C. Przyjął, że ziemski system klimatyczny od razu ociepla się w odpowiedzi na zmiany stężenia CO2, co jest sporym uproszczeniem –współczesne modele odtwarzają opóźnienie pomiędzy zmianą bilansu radiacyjnego planety a stopniowym nagrzewaniem się oceanów.

Broecker nie uwzględnił w swoim modelu innych gazów cieplarnianych; ponieważ jednak ocieplający wpływ rosnących stężeń metanu, podtlenku azotu i innych gazów cieplarnianych został mniej więcej skompensowany przez chłodzący wpływ emitowanych przez nas aerozoli, uproszczenie to nie wpłynęło znacząco na zgodność prognozy z obserwacjami.

Broecker przedstawił swoją prognozę w okresie, w którym szybki wzrost emitowanych przez fabryki i elektrownie aerozoli siarczanowych przyczyniał się do ochładzania klimatu (czytaj też Mit: W latach 70. XX wieku naukowcy przewidywali epokę lodowcową). Swój artykuł rozpoczął stwierdzeniem, że „istnieją silne argumenty, że dotychczasowy trend ochładzający, przejdzie mniej więcej w ciągu dekady w ocieplenie powodowane przez dwutlenek węgla”.

Hansen i in., 1981

Dr James Hansen z NASA wraz z zespołem opublikowali w 1981 roku artykuł, w którym (również w oparciu o prosty model bilansu energetycznego) przedstawili prognozę przyszłego ocieplenia. W odróżnieniu od Broeckera uwzględnili jednak bezwładność termiczną oceanów, czyli to, że nagrzewają się powoli. Przyjęli czułość klimatu równą 2,8°C (przedstawili też dodatkowo scenariusze z innymi czułościami, od 1,4 do 5,6°C).

Rysunek 3. Prognoza ocieplenia klimatu przedstawiona przez Hansena w 1981 roku. Czarna linia pokazuje scenariusz wzrostu emisji CO2 o 4% rocznie po 1981 roku. Szara linia pokazuje scenariusz wzrostu emisji CO2 o 2% rocznie po 1981 roku.

Hansen i jego zespół przedstawili szereg różnych scenariuszy, uwzględniających różne przyszłe emisje i czułość klimatu. Na rysunku powyżej pokazane zostały dwa scenariusze: szybkiego wzrostu emisji CO2 (czarna linia) oraz wolniejszego wzrostu emisji CO2 (szara linia). Scenariusz szybkiego wzrostu lekko przeszacowywał rzeczywiste tempo emisji, jednak przyjęcie niższej od obecnie zakładanej czułości klimatu spowodowało, że prognoza wzrostu temperatury okazała się lekko zaniżona w stosunku do tego, co faktycznie nastąpiło.

Hansen i in., 1988

Opublikowany w 1988 roku przez Hansena i kolegów artykuł przedstawiał wyniki uzyskane za pomocą jednego z pierwszych modeli klimatu, bazującego na stosowanych także obecnie rozwiązaniach: obliczenia prowadzone były dla węzłów siatki (o oczkach rozmiaru 8 stopni szerokości geograficznej na 10 stopni długości geograficznej) z dziewięcioma pionowymi warstwami atmosfery; model uwzględniał aerozole, inne niż CO2 gazy cieplarniane oraz podstawową dynamikę chmur.

W artykule przedstawione zostały trzy różne scenariusze związane z różnymi przyszłymi emisjami gazów cieplarnianych.

Rysunek 4. Prognoza ocieplenia klimatu przedstawiona przez Hansena w 1988 roku.

Scenariusz A zakładał wykładniczy szybki wzrost emisji, prowadzący do wyższych niż faktycznie zaobserwowane stężeń CO2 i innych gazów cieplarnianych. W Scenariuszu C po roku 2000 emisje ulegały znacznej redukcji, do poziomu, na którym następowało ustabilizowanie wymuszania radiacyjnego gazów cieplarnianych.

Scenariusze A i C były w pracy podane jako skrajne, zaś jako najbardziej prawdopodobny podany był Scenariusz B.

Zakładał on spowolnienie wzrostu emisji CO2, prowadzące do osiągnięcia w 2016 roku stężenia 401 ppm – praktycznie identycznego z rzeczywistym (403 ppm).

Zakładał też dalszy wzrost emisji chlorofluorowęglowodorów (CFC) i innych substancji, których stosowanie zostało ograniczone przez mający na celu ochronę warstwy ozonowej Protokół Montrealski z 1987 roku. Wolniejszy od prognozy był też faktyczny wzrost emisji metanu. W sumie rzeczywiste wymuszanie radiacyjne w ostatnich latach leży pomiędzy prognozami ze Scenariuszy B i C. Nic więc dziwnego, że mierzone temperatury również przypadają w obszarze między prognozami Scenariuszy B i C.

Wysoka zgodność prognozy z rzeczywistością jest tym bardziej intrygująca, że model użyty do jej przygotowania zakładał czułość klimatu równą 4,2°C. To wartość leżąca w górnym zakresie prawdopodobieństwa obecnie przyjmowanej czułości klimatu (w granicach 1,5-4,5°C, z najbardziej prawdopodobną wartością 3°C). Ostatnio pojawia się sporo opracowań prowadzących do wniosku, że czułość klimatu może leżeć właśnie w górnym zakresie szacunków. Zgodność prognozy Hansena z obserwacjami też to sugeruje.

Więcej n/t prognozy Hansena z 1988 roku piszemy w artykule Mit: Przewidywania Jamesa Hansena z 1988 roku były błędne.

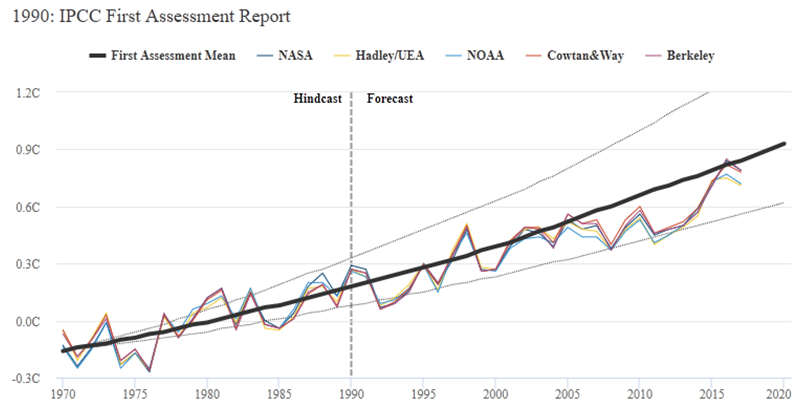

Pierwszy raport IPCC, 1990

Wykorzystane w Pierwszym Raporcie Oceniającym IPCC (First Assessment Report, FAR) z 1990 roku modele były relatywnie proste (patrz rys. 1). Przedstawione zostały wyniki symulacji w scenariuszu biznes-jak-zwykle (Business As Usual, BAU), zakładającym szybki wzrost atmosferycznej koncentracji CO2, sięgającej w 2016 roku 418 ppm (o kilkanaście ppm powyżej rzeczywistego), a także szybszy od faktycznego wzrost koncentracji chlorofluorowęglowodorów i innych gazów przemysłowych.

Wynikające z tego przeszacowanie wymuszania radiacyjnego zostało częściowo skompensowane przyjęciem dość niskiej czułości klimatu 2,5°C (z zakresem ufności 1,5-4,5°C). W sumie można powiedzieć, że prognoza wzrostu temperatury z pierwszego raportu IPCC okazała się całkiem dokładna.

Rysunek 5. Prognoza ocieplenia z 1 raportu IPCC z 1990 roku. Średnia prognoza pokazana linią czarną, dolna i górna granica prognozowanego przedziału niepewności oznaczona liniami szarymi.

Drugi raport IPCC, 1995

W drugim raporcie IPCC (Second Assessment Report, SAR) z 1995 roku średni scenariusz emisji „IS92a” prognozował w 2016 roku stężenie CO2 równe 405 ppm, praktycznie dokładnie zgodne z rzeczywistością (403 ppm).

Przyjęta niska czułość klimatu 2,5°C (zakres 1,5-4,5°C), połączona z wyższym (4,37 W/m2) niż obecnie zakładanym (3,7 W/m2) wpływem radiacyjnym dwutlenku węgla, poskutkowały jednak zaniżeniem wzrostu temperatury, który okazał się znacznie większy od prognozowanego.

Rysunek 6. Prognoza ocieplenia z 2 raportu IPCC z 1995 roku. Średnia prognoza pokazana linią czarną, dolna i górna granica prognozowanego przedziału niepewności oznaczona liniami szarymi.

Trzeci raport IPCC, 2001

W trzecim raporcie IPCC (Third Assessment Report, TAR) z 2001 roku wprowadzono nowy zestaw społeczno-ekonomicznie zróżnicowanych scenariuszy pod nazwą SRES, uwzględniających cztery różne trajektorie przyszłych emisji. Tu przyjrzymy się scenariuszowi A2, choć do 2020 roku różnice między poszczególnymi scenariuszami są relatywnie niewielkie. Scenariusz emisji A2 zakładał w 2016 roku stężenie CO2 równe 406 ppm, dobrze zgodne z rzeczywistością.

W wykorzystanych modelach czułość klimatu wynosiła 2,8°C (zakres 1,5-4,5°C), a prognozowany wzrost temperatury okazał się lekko zaniżony.

Rysunek 7. Prognoza ocieplenia z 3 raportu IPCC z 2001 roku. Średnia prognoza pokazana linią czarną, dolna i górna granica prognozowanego przedziału niepewności oznaczona liniami szarymi.

Czwarty raport IPCC, 2007

W czwartym raporcie IPCC (AR4), z 2007 roku, obliczenia były wykonywane za pomocą znacząco udoskonalonych modeli, uwzględniających więcej procesów (m.in. biogeochemię cyklu węglowego, procesy związane z lodem i zmianami roślinności) i prowadzących obliczenia na dużo mniejszych oczkach siatki.

Rysunek 8. Zmiana w gęstości siatek modeli klimatycznych pomiędzy pierwszym raportem IPCC w 1990 a najnowszym raportem z roku 2013. Źródło: IV i V raport IPCC.

W 4 Raporcie IPCC wykorzystano te same scenariusze co w 3 Raporcie. Średnia czułość klimatu dla wykorzystanych modeli była obliczana przez same modele i wynosiła 3,26°C (zakres 2,1-4,4°C), a prognozowany wzrost temperatury okazał się bliski rzeczywistego.

Rysunek 9. Prognoza ocieplenia z 4 raportu IPCC z 2007 roku. Średnia prognoza (scenariusz A1B) pokazana linią czarną, dolna i górna granica prognozowanego przedziału niepewności oznaczona liniami szarymi.

Piąty raport IPCC, 2013

Najnowszy piąty raport IPCC (AR5) z 2013 roku obliczenia bazuje na jeszcze bardziej zaawansowanych względem swojego poprzednika AR4 modelach, mniejszy jest też zakres niepewności.

Rysunek 10. Prognoza ocieplenia z 5 raportu IPCC z 2013 roku. Średnia prognoza pokazana linią czarną, dolna i górna granica prognozowanego przedziału niepewności oznaczona liniami szarymi. Czarna linia kreskowana pokazuje„mieszane dane” obliczanej przez modele temperatury symulowane zgodnie ze sposobami pomiarów (opis w tekście poniżej wykresu).

W AR5 wprowadzony został nowy zestaw scenariuszy zmian koncentracji gazów cieplarnianych, określany jako Representative Concentration Pathways, RCP (więcej o tym piszemy o nich tutaj). Ponieważ raport jest stosunkowo świeży, scenariusze dla najbliższych lat (do 2020 roku) nie różnią się od siebie znacząco – wiadomo przecież, że w tych ramach czasowych trudno liczyć na istotną zmianę w emisjach.

Bezpośrednie porównywanie rezultatów symulacji temperatury z pomiarami jest wbrew pozorom wcale nie takie oczywiste. Kiedy analizujemy rezultaty pracy modeli chcąc dowiedzieć się, jakie zmiany temperatury prognozują, najczęściej patrzymy na temperaturę powietrza przy powierzchni Ziemi. Tymczasem obserwacje temperatury pochodzą zarówno z pomiarów temperatury powietrza, jak i temperatury powierzchni wody oceanu. Aby to uwzględnić, naukowcy zaczęli ostatnio wprowadzać do modeli możliwość pozyskiwania z nich danych odpowiadających sposobom pomiarów (czyli dane o temperaturze powietrza nad lądami i morza na powierzchni morza). Ponieważ temperatura powierzchni wody w ocieplającym się klimacie rośnie wolniej od temperatury powietrza, wzrost temperatury mierzony w taki sposób (i obliczany przez modele) będzie trochę niższy niż wzrost temperatury powietrza przy powierzchni ziemi. Różnicę widać na rys. 9 – czarna linia ciągła pokazuje zwracany przez modele wzrost temperatury przy powierzchni ziemi, linia przerywana zaś zwracany przez modele wzrost temperatury obliczany w oparciu o pomiary temperatury na lądzie i wody na powierzchni oceanów.

Prognozowany wzrost temperatury jest bliski rzeczywistego.

Rysunek 10: Współczesny superkomputer. Zdjęcie: jacquesbron.com, Dreamstime.com.

Podsumowanie

Modele klimatu z ostatnich 40 lat i ich prognozy zmian temperatury powierzchni Ziemi całkiem dobrze przeszły próbę czasu. Niektóre dały wyniki trochę zaniżone, inne trochę zawyżone, ale biorąc pod uwagę różne założenia odnośnie scenariuszy emisji poszczególnych gazów cieplarnianych i czułości klimatu tego właśnie należało oczekiwać.

Twierdzenia, że modele klimatu „są do niczego” lub że „znacząco przeszacowują faktyczne ocieplenie” są zupełnie nieuzasadnione. Wysoka zgodność między prognozami i obserwacjami stanowi mocny argument, że oszacowania przyszłych zmian klimatu okażą się równie dobre.

Istnieje oczywiście możliwość, że wraz z wychodzeniem klimatu Ziemi w coraz większym stopniu poza zakres z ostatnich tysięcy, a nawet milionów lat (czytaj Koniec Holocenu, Zmiany klimatu kiedyś i dziś – w 80 lat do klimatu z czasów dinozaurów?) klimat zacznie reagować w sposób nieprzewidywalny. Niestety większość z tych niepewności znajduje się nie po stronie „będzie lepiej”, ale po stronie „następstwa będą poważniejsze”. Należą do nich np. destabilizacja wiecznej zmarzliny czy gwałtowne zmiany cyrkulacji oceanicznej.

W prognozowaniu przyszłej zmiany klimatu największej niepewności względem tego, co się zdarzy, możemy się spodziewać nie ze strony modeli klimatu lecz ilości gazów cieplarnianych, które wpuścimy do środowiska.

NauaoKlimacie.pl, Marcin Popkiewicz na podst. Analysis: How well have climate models projected global warming?